计算机行业_DEEPSEEK_V3发布_技术创新和商业化落地的共振_241228_财通证券_11页

文章目录

DeepSeek-V3 发布,技术创新和商业化落地的共

证券研究报告

投资评级:看好(维持)

最近 12 月市场表现

分析师 杨烨

SAC 证书编号:S0160522050001

[email protected]

核心观点

DeepSeek-V3 正式发布,性能对齐海外头部模型:12 月 26 日,深度求索 DeepSeek 发布了其 DeepSeek-V3 模型。该模型是一款强大的混合专家(MoE)语言模型,拥有 671B 参数,激活 37B,在 14.8T token 上进行了预训练。在多种任务中表现卓越,训练高效且成本效益显著。DeepSeek-V3 在多项基准测试中表现优异,比肩世界顶级模型。

国内头部自研开源模型,创新引入训练新策略: DeepSeek-V3 的基础架构仍在 Transformer 架构内,同时采用了多头潜在注意力(MLA)和DeepSeekMOE(DeepSeek 混合专家)机制,以实现更高效推理和更具经济性价比的训练。DeepSeek-V3 本次创新在于额外引入了无辅助损失的负载均衡策略(auxiliary-loss-free load balancing strategy)和多 token 预测策略(MTP),两者对模型训练过程进行了创新性的优化。在 DeepSeek-V3 后训练过程中,DeepSeek 结合了监督微调(SFT)和强化学习(RL),使得模型可以更好的与人类偏好对齐,增强其泛化能力,并更好地处理未见过的数据和任务。

相关报告

- 《OpenAI 12 天直播带来的几点产业思考》 2024-12-23

- 《AI 眼镜或将成为下一代终端》2024-12-22

- 《智驾月报:车市延续景气,FSDv13开始测试》 2024-12-20

完整训练仅需 278.8 万 H800GPU 小时,高性价比追求普惠 AGI:DeepSeek-V3 的完整训练仅需 278.8 万 H800GPU 小时,包含预训练、上下文长度扩展和后训练。同时,DeepSeek-V3 采用了 FP8 混合精度训练框架,这是首次在超大规模模型上验证 FP8 训练的可行性和有效性。综合评估表明,DeepSeek-V3 是目前最强的开源模型,性能可与闭源模型如 GPT-4o-0513 和Claude-3.5-Sonnet-1022 相媲美。另外,随着性能更强、速度更快的 DeepSeek-V3 更新上线,DeepSeek-V3 模型 API 服务定价也将调整为每百万输入tokens 0.5 元(缓存命中)/ 2 元(缓存未命中),每百万输出 tokens 8 元,是当前模型性能/价格比最优的模型服务。

风险提示:技术迭代不及预期的风险;商业化落地不及预期的风险;政策支持不及预期风险;全球宏观经济风险。

请阅读最后一页的重要声明!

免责申明:

- 本资料来源于网络公开渠道,版权归属版权方;

- 本资料仅限会员学习使用,如他用请联系版权方;

- 会员费用作为信息收集整理及运营之必须费用;

- 如侵犯您的合法权益,请联系客服微信将及时删除

行业报告资源群

- 进群福利:进群即领万份行业研究、管理方案及其他学

习资源,直接打包下载 - 每日分享:6份行研精选报告、3个行业主题

- 报告查找:群里直接咨询,免费协助查找

- 严禁广告:仅限行业报告交流,禁止一切无关信息

微信扫码,长期有效

知识星球 行业与管理资源

专业知识社群:每月分享8000+份行业研究报告、商业计划、市场研究、企业运营及咨询管理方案等,涵盖科技、金融、教育、互联网、房地产、生物制药、医疗健康等;已成为投资、产业研究、企业运营、价值传播等工作助手。

内容目录

1DeepSeek-V3 正式发布,性能对齐海外头部模型. 3

2国内头部自研开源模型,创新引入训练新策略… . 4

2.1 引入无辅助损失的负载均衡策略,提高模型性能 ………. . 4

2.2 设立多 token 预测训练目标 MITP,增加训练信号的密度..

2.3 结合监督微调和强化学习后训练,性能比肩领先闭源模型 … ……… 6

2.3.1 SFT 和 RL 帮助模型调整生成策略,新任务适应能力提升 ……….. ….. 6

2.3.2 SFT 和 RL 的结合,显著提升多个基准测试性能 ………. … 8

3完整训练仅需278.8万H800GPU小时,高性价比追求普惠AGI… .. 8

4 风险提示… 9

图表目录

图 1. DeepSeek 发布 DeepSeek-V3 模型

图 2.DeepSeek-V3 及其同类产品的基准性能比较…. .. 3

图3. DeepSeek-V3 的基本架构…. . 4

图 4.无辅助损失的平衡策略的消融结果.. . 5

图 5. 多 token 预测(MTP)策略的消融结果 ………. . 6

图 6. DeepSeek-V3 展示解题时的 CoT ……….. 7

图 7.DeepSeek-V3 实际输出结果…. 7

图8.DeepSeek-V3与其他代表性模型的对比…. . 8

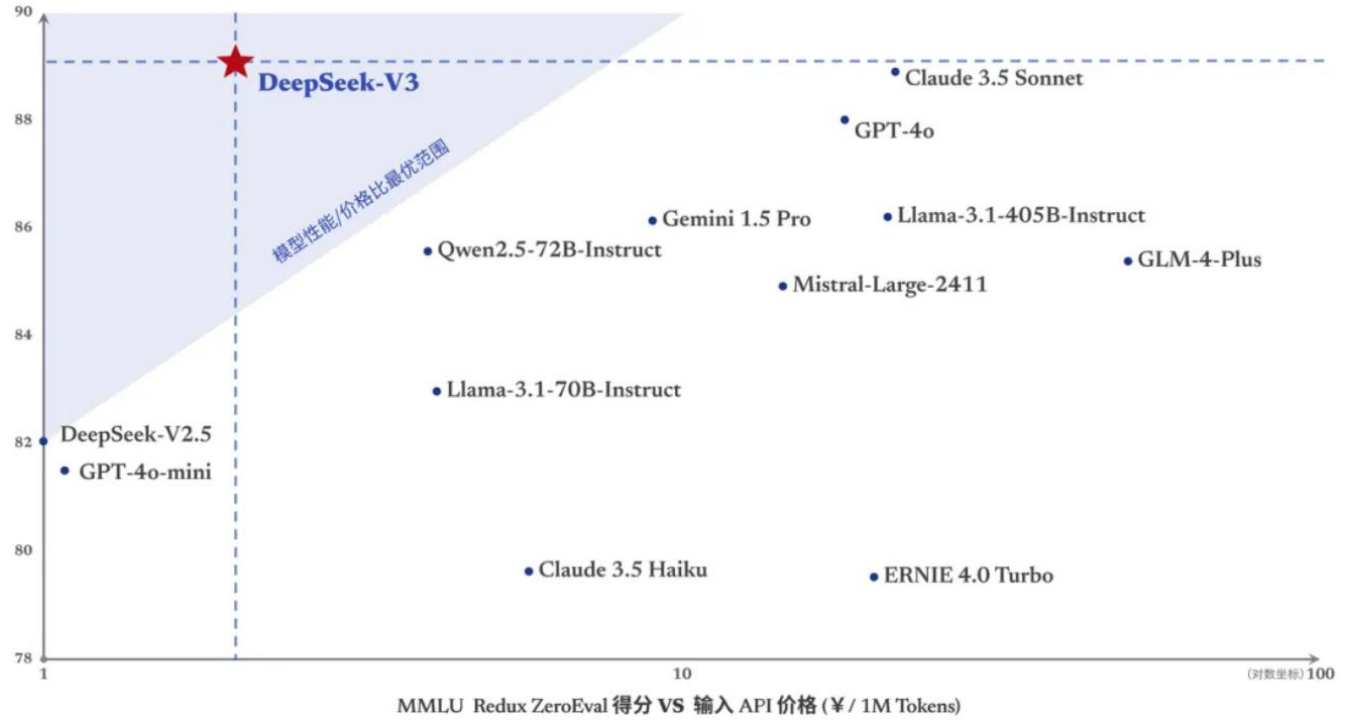

图 9. MMLU Redux ZeraEval 得分 vs. 输入 API 价格(¥/1M Tokens) …….. 9

1 DeepSeek-V3 正式发布,性能对齐海外头部模型

DeepSeek-V3 正式发布。12 月 26 日,深度求索 DeepSeek 发布了其 DeepSeek-V3模型。该模型是一款强大的混合专家(MoE)语言模型,拥有 671B 参数,激活37B,在 14.8T token 上进行了预训练。在多种任务中表现卓越,训练高效且成本效益显著。

图1. DeepSeek 发布 DeepSeek-V3 模型

数据来源:DeepSeek-V3 模型官方,财通证券研究所

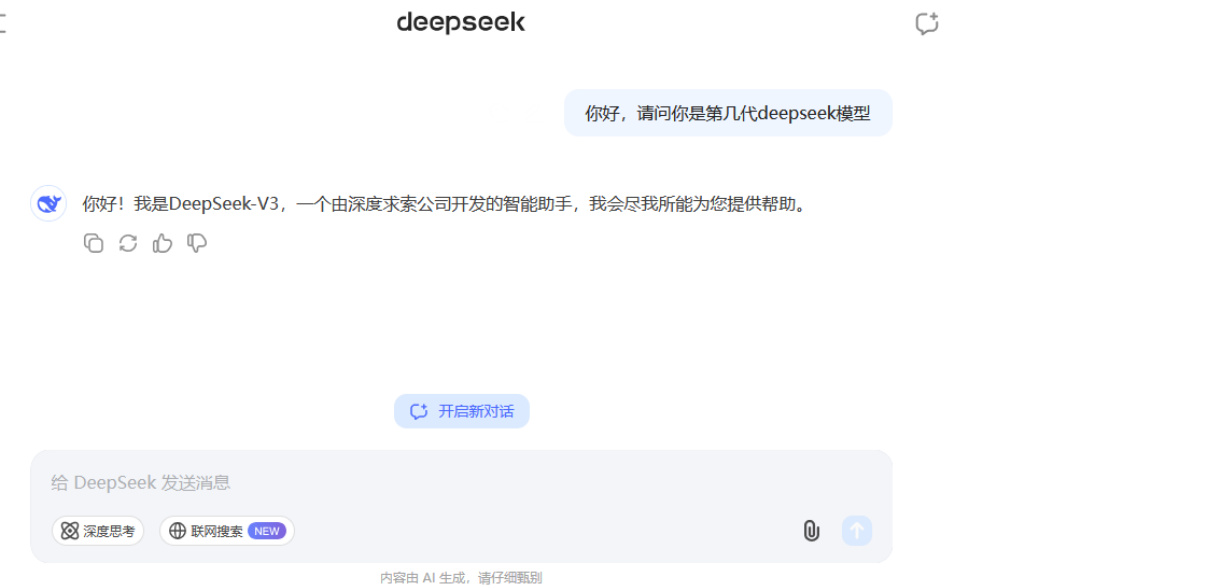

DeepSeek-V3 在多项基准测试中表现优异,比肩世界顶级模型。根据 DeepSeek 发布的最新论文,DeepSeek-V3多项评测成绩超越了Qwen2.5-72B和Llama-3.1-405B等其他开源模型,并在性能上和世界顶尖的闭源模型 GPT-4o(0513 版本)以及Claude-3.5-Sonnet 不分伯仲。如下图 2所示,在MATH500(EM)测试中,DeepSeek-V3 的准确率最高,为 $90.2%$ ;在 Codeforces(Percentile)测试中,DeepSeek-V3 的准确率为 $51.6%$ ,是可比模型中最高。

图2. DeepSeek-V3 及其同类产品的基准性能比较

数据来源:DeepSeek 官网,财通证券研究所

2 国内头部自研开源模型,创新引入训练新策略

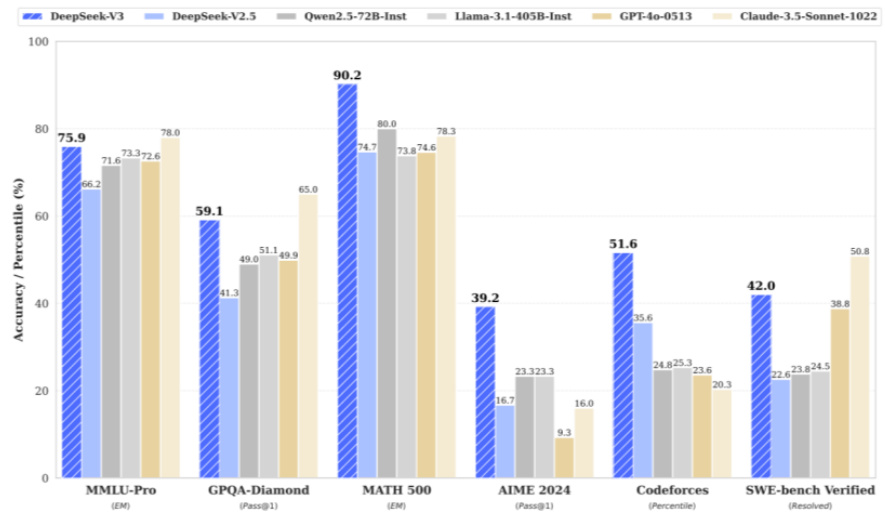

基于多头潜在注意力,实现高效推理。DeepSeek-V3 的基础架构仍在 Transformer架构内,同时采用了多头潜在注意力(Multi-Head Latent Attention,简称 MLA)和 DeepSeekMOE(DeepSeek 混合专家)机制,以实现更高效推理和更具经济性价比的训练。多头潜在注意力机制(MLA)在 DeepSeek-V2 模型中就被提出和使用,核心思想是通过压缩键值(Key-Value,简称 KV)缓存到一个潜在向量中,以减少推理过程中所需的内存和计算资源,提高模型推理效率。简而言之,MLA是将大模型中的单词信息压缩成更小的信息单元,以帮助模型以更有效和节省的方式处理大量数据。

图3. DeepSeek-V3 的基本架构

数据来源:DeepSeek 官网,财通证券研究所

2.1 引入无辅助损失的负载均衡策略,提高模型性能

引入无辅助损失的负载均衡策略。DeepSeek-V3 的基本架构与 DeepSeek-V2 类似,但在 DeepSeek-V3 中额外引入了无辅助损失的负载均衡策略(auxiliary-loss-freeload balancing strategy), 以在减轻因努力确保负载平衡(effort to ensure load balance)而导致的性能下降。

具体而言,负载平衡(load balancing)对模型的高效训练和运行至关重要,目的是在多个计算资源之间优化资源使用、最大化吞吐量、最小化响应时间,并避免任何单一点过载。如果专家(expert)之间的负载不均衡,可能会导致计算资源的浪费和性能下降。传统的方法会引入辅助损失(auxiliary loss)来促使负载平衡,虽然在一定程度上可以促使负载平衡,但太大的辅助损失会对模型的整体性能产生负面影响。此次 DeepSeek-V3 引入的无辅助损失的负载均衡策略是试图在不依赖辅助损失(或减少其负面影响)的情况下,动态调整偏差项来实现负载平衡,从而使模型更好的学习关键信息,并在推理阶段更准确的生成结果。

图4.无辅助损失的平衡策略的消融结果

| Benchmark (Metric) | # Shots | Small MoE Aux-Loss-Based Aux-Loss-Free | Small MoE | Large MoE Aux-Loss-Based | Large MoE Aux-Loss-Free |

| # Activated Params | 2.4B | 2.4B | 20.9B | 20.9B | |

| # Total Params | 15.7B | 15.7B | 228.7B | 228.7B | |

| # Training Tokens | 1.33T | 1.33T | 578B | 578B | |

| Pile-test (BPB) | 0.727 | 0.724 | 0.656 | 0.652 | |

| BBH (EM) | 3-shot | 37.3 | 39.3 | 66.7 | 67.9 |

| MMLU (EM) | 5-shot | 51.0 | 51.8 | 68.3 | 67.2 |

| DROP (F1) | 1-shot | 38.1 | 39.0 | 67.1 | 67.1 |

| TriviaQA (EM) | 5-shot | 58.3 | 58.5 | 66.7 | 67.7 |

| NaturalQuestions (EM) | 5-shot | 23.2 | 23.4 | 27.1 | 28.1 |

| HumanEval (Pass@1) | O-shot | 22.0 | 22.6 | 40.2 | 46.3 |

| MBPP (Pass@1) | 3-shot | 36.6 | 35.8 | 59.2 | 61.2 |

| GSM8K (EM) | 8-shot | 27.1 | 29.6 | 70.7 | 74.5 |

| MATH (EM) | 4-shot | 10.9 | 11.1 | 37.2 | 39.6 |

数据来源:DeepSeek 官方,财通证券研究所注:从表格来看,在大部分的基准测试和任务中,使用无辅助损失的策略(Aux-Loss-Free)的模型在不同规模的混合专家模型上都表现出更好的性能。表格中“shot”表示提供给模型学习的示例数量。

2.2 设立多 token 预测训练目标 MTP,增加训练信号的密度

DeepSeek-V3 模型的另一项创新为引入多 token 预测策略(multi-token predictionstrategy,简称 MTP)。在传统的语言模型训练中,通常是逐个预测下一个单词(next-token prediction)。而 MTP 可以尝试扩展预测范围,一次性预测多个未来token。这样做的一个主要目的是增加训练信号的密度,使模型在每次预测时能够从更多的未来信息中学习,从而提高数据效率。

具体而言,MTP 可以同时考虑接下来的几个单词,让模型更全面地理解上下文关系,更好地捕捉文本中的语义和语法信息,进而更高效地利用训练数据进行学习。

生成的文本更加流畅、合理,而不是仅仅局限于逐个单词的生成,缺乏对整体的规划。

图5.多 token 预测(MTP)策略的消融结果

| Benchmark (Metric) | # Shots | Small MoE Baseline | Small MoE w/ MTP | Large MoE Baseline | Large MoE w/ MTP |

| # Activated Params (Inference) | 2.4B | 2.4B | 20.9B | 20.9B | |

| # Total Params (Inference) | 15.7B | 15.7B | 228.7B | 228.7B | |

| # Training Tokens | 1.33T | 1.33T | 540B | 540B | |

| Pile-test (BPB) | 0.729 | 0.729 | 0.658 | 0.657 | |

| BBH (EM) | 3-shot | 39.0 | 41.4 | 70.0 | 70.7 |

| MMLU (EM) | 5-shot | 50.0 | 53.3 | 67.5 | 66.6 |

| DROP (F1) | 1-shot | 39.2 | 41.3 | 68.5 | 70.6 |

| TriviaQA (EM) | 5-shot | 56.9 | 57.7 | 67.0 | 67.3 |

| NaturalQuestions (EM) | 5-shot | 22.7 | 22.3 | 27.2 | 28.5 |

| HumanEval (Pass@1) | O-shot | 20.7 | 26.8 | 44.5 | 53.7 |

| MBPP (Pass@1) | 3-shot | 35.8 | 36.8 | 61.6 | 62.2 |

| GSM8K (EM) | 8-shot | 25.4 | 31.4 | 72.3 | 74.0 |

| MATH (EM) | 4-shot | 10.7 | 12.6 | 38.6 | 39.8 |

数据来源:DeepSeek 官方,财通证券研究所注:从表格来看,使用MTP 策略的基准模型在性能上有所提升,不同任务和不同规模的模型提升幅度有所不同。

2.3 结合监督微调和强化学习后训练,性能比肩领先闭源模型

在 DeepSeek-V3 后训练过程中,DeepSeek 结合了监督微调(Supervised Fine–Tuning,简称 SFT)和强化学习(Reinforcement Learning,简称 RL),使得模型可以更好的与人类偏好对齐,增强其泛化能力,并更好地处理未见过的数据和任务。

2.3.1 SFT 和 RL 帮助模型调整生成策略,新任务适应能力提升

DeepSeek-v3 在 SFT 和 RL 环节分别进行了优化,模型适应能力提升明显。

在 SFT 训练中,DeepSeek 针对推理相关数据集(如数学、代码竞赛、逻辑谜题等),利用内部的 DeepSeek-R1 模型生成数据;针对非推理数据(如创意写作、角色扮演、简单问答等),使用 DeepSeek-V2.5 生成响应,并由人类注释者验证数据的准确性和正确性。在 RL 训练中,DeepSeek 采用了基于规则和基于模型的奖励模型(rewardmodel)。对于可以使用特定规则验证的问题(如某些数学问题、编程题等),使用基于规则的奖励系统。对于自由形式的真实答案问题或无明确真实答案的问题(如创意写作等),使用基于模型的奖励模型。该模型从 DeepSeek-V3的 SFT 检查点进行训练,并通过构建偏好数据来增强其可靠性,偏好数据不仅提供最终奖励,还包括导致奖励的思维链(Chain of Thought,简称 CoT),以减少奖励黑客(reward hacking)风险。

| 我得先算F(3): | ||

| 求函数f(x)=x3-3x2+2f(x)=x3-3x2+2在区间[0,3][0,3]上的定积分 | 等一下,81/4是多少?81除以4等于20.25 | |

| 所以, F(3) = 20.25 - 21 = -0.75 | ||

| 已深度思考(用时24秒) | ||

| 好,我有一道定积分的题目,就是求函数f(x)=x”-3x²+2在区间[0,3]上的定积分。我得好好想想怎么解这道题。 | 然后算F(0): | |

| 首先,我道定积分是求函数在某个区间内的面积,或者说是默积的变化量,具体来说,就是从x=0到x=3这个区间 | F(0) = (04)/4 - 0 + 2*0 = 0 - 0 + 0 = 0 | 在[1,1+√3]区间内,函数从0下降到负值,然后在x=1+V3又包到0 |

| 内,f(x)的曲线与×轴之间的面积 | 所以, 定积分是 F(3) - F(0) = -0.75 - 0 = -0.75 | 所以,定积分是负的,表示在这个区间内,通数在某些部分是在×轴下方的。 |

| 我记得求定积分的方法是先求函数的不定积分,然后再用牛额-菜布尼益公式,也就是上限减下限。 | 但是,定积分表示面积,面积怎么会是负数呢?难道在这个区间内,函数有部分在×轴下方? | 不过,我计算得到定积分是-0.75,这可能是因为在[1,3]区用内,腾数值是负的,而在[0,1区同内是正的,整体积分 为负,表示负面积大于正面积。 |

| 那我先来求f(x)的不定积分。f(x)=x-3x²+2.那不定分就是 | 让我画—下f(x)=x3-3x²+2的图像,看者在[0,3]这个区间内,函数的图像形状。 | 不以,我再检查一下我的计其,香否有没有其情 |

| xp[ + xp x[ -xp x = xp (2 + zxE - x)] | 首先。求函数的零点,也就是f(x)=0的解。 | F(x) = (x)/4 -x + 2x |

| 我记得 [×^n dx = (x^(n+1)/(n+1) + C, 其中 C 是常数 | x3 - 3x2 + 2 = 0 | F(3) = (81)/4 - 27 +6 = 20.25 - 27 + 6 = (20.25 + 6) -27 = 26.25 - 27 =-0.75 |

| 所以, [x dx = (x)/4 | 这个方程好像有点难解,我试试因式分解。 | F(0) = 0 |

| [x² dx = (x²)/3 | 假设x=1是个根,代入f(1)=1-3 +2=0,是的。x=1是个根。 | 所以,定积分确实是-0.75, |

| ∫dx = x | 所以, f(x) 可L以分解为 (x-1)(x² - 2x - 2) = 0 | 也许找的理解有问题,我再总域 |

| 所以,不定积分是: | 然后,解x²-2x-2=0,用求根公式: | 定积份的续可以是负的,这表示在的分这同内,函数在×轴下方的面积更大。 |

| (x)/4 - 3*(x²)/3 + 2x + C = (x)/4 - x² + 2x + C | x = [2 ± v(4 + 8)] / 2 = [2 ± v12]/2 = [2 ± 2v3]/2 = 1 ± v3 | 如果我想求绝对面积,应该取地对值,或者分段积分。 |

| 好的,现在我有了不定积分,接下来就是用牛顿-菜布尼兹公式,也就是F(b)-F(a),其中F是不定积分,a和b是积分 | 所以,零点是×=1 和×=1+√3, x=1-√3 | 但题目只要求定积分。所以答家应该是-0.75, |

| 的下限和上限。 这里 a=0, b=3, | 其中。1-√3 约等于 -0.732, 不在 [0,3] 内. 1 和 1+√3 约等于 2.732 都在[0,3] 内。 | 不过,为了确保方无一失,我再用另一种方法验证一下,比知数值分,比加标形法则或者辛营森法购 |

| 所以。定积分就是 F(3) - F(0) | 所以,在[0,1] 区间内,f(x) 从 f(0)=2 开始,经过 x=1 时 f(1)=0, 可能在这个区间内函数值都是正的。 | 不过,这可能比较麻模,我还是相质的符号积分结果吧 所以,最后的答家是-3/4或者-0.75. |

数据来源:DeepSeek-V3 模型官方,财通证券研究所

最终,在 SFT 阶段学习到的通用知识和模式,结合 RL 阶段对不同任务和场景下奖励信号的适应,帮助模型在面对新的任务和数据时能够更快地调整策略,生成合理的输出。

图6. DeepSeek-V3 展示解题时的 CoT

图7. DeepSeek-V3 实际输出结果

首先,我们需要求函数 $f(x)=x^{3}-3x^{2}+2$ 在区间 $[0,3]$ 上的定积分。

$1.$ 求不定积分:

$$ \int(x^{3}-3x^{2}+2)d x={\frac{x^{4}}{4}}-x^{3}+2x+C $$

$2.$ 应用牛顿-莱布尼兹公式:

$$ \int_{0}^{3}(x^{3}-3x^{2}+2)d x=\left[{\frac{x^{4}}{4}}-x^{3}+2x\right]_{0}^{3} $$

3.计算上限和下限的值:

$$ F(3)={\frac{3^{4}}{4}}-3^{3}+2\cdot3={\frac{81}{4}}-27+6=20.25-27+6=-0.75 $$

$$ {\cal F}(0)=\frac{0^{4}}{4}-0^{3}+2\cdot0=0 $$

$4.$ 计算定积分:

$$ \int_{0}^{3}(x^{3}-3x^{2}+2)d x=F(3)-F(0)=-0.75-0=-0.75 $$

因此,函数 $f(x)=x^{3}-3x^{2}+2$ 在区间 $[0,3]$ 上的定积分为-0.75。

数据来源:DeepSeek-V3 模型官方,财通证券研究所

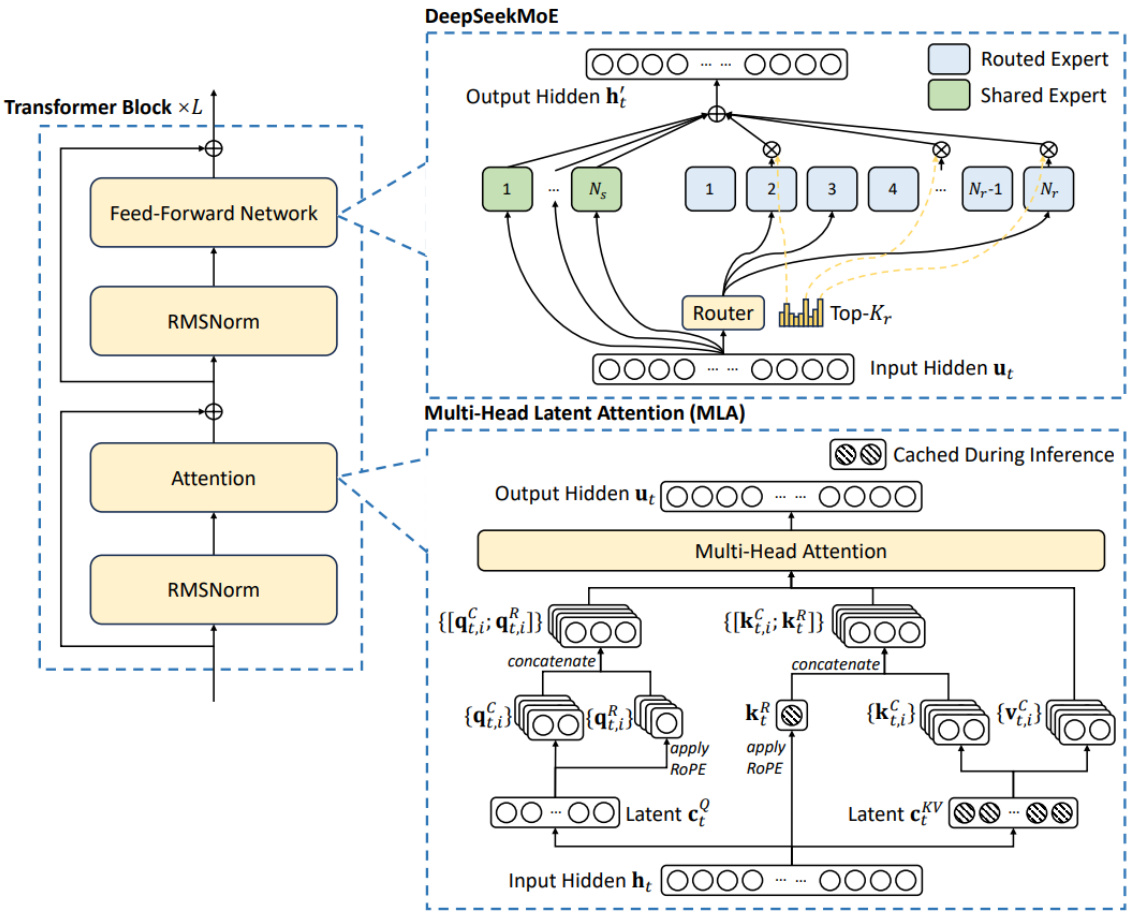

2.3.2 SFT 和 RL 的结合,显著提升多个基准测试性能

SFT 和 RL 的结合使得模型在多个基准测试中的性能得到显著提升。在标准基准测试中,如 MMLU、DROP、GPQA 等,DeepSeek-V3 在经过 SFT 和 RL 后表现出色,超过了其他开源模型,甚至在一些任务上接近或达到领先闭源模型的水平。在实际应用场景中,如在处理复杂的编程任务、知识问答、文本创作等任务时,模型能够更好地理解任务要求,生成更合理、更准确的输出。

图8. DeepSeek-V3 与其他代表性模型的对比

| Benchmark (Metric) | DeepSeek DeepSeek| V2-0506 | V2.5-0905 | 72B-Inst. | Qwen2.5 LLaMA-3.1 Claude-3.5- GPT-4o|DeepSeek | 0513 | V3 | ||

| 405B-Inst.Sonnet-1022 | ||||||||

| Architecture #Activated Params | MoE 21B | MoE 21B | Dense 72B | Dense 405B | MoE 37B | |||

| # Total Params | 236B | 236B | 72B | 405B | 671B | |||

| MMLU (EM) | 78.2 | 80.6 | 85.3 | 88.6 | 88.3 | 87.2 | 88.5 | |

| MMLU-Redux (EM) | 77.9 | 80.3 | 85.6 | 86.2 | 88.9 | 88.0 | 89.1 | |

| MMLU-Pro (EM) DROP (3-shot F1) | 58.5 | 66.2 | 71.6 | 73.3 | 78.0 | 72.6 | 75.9 | |

| English | 83.0 | 87.8 | 76.7 | 88.7 | 88.3 | 83.7 | 91.6 | |

| IF-Eval (Prompt Strict) GPQA-Diamond (Pass@1) | 57.7 35.3 | 80.6 | 84.1 | 86.0 | 86.5 | 84.3 | 86.1 | |

| 41.3 | 49.0 | 51.1 | 65.0 | 49.9 | 59.1 | |||

| SimpleQA (Correct) | 9.0 | 10.2 | 9.1 | 17.1 | 28.4 | 38.2 | 24.9 | |

| FRAMES (Acc.) LongBench v2 (Acc.) | 66.9 | 65.4 | 69.8 | 70.0 | 72.5 | 80.5 | 73.3 | |

| 31.6 | 35.4 | 39.4 | 36.1 | 41.0 | 48.1 | 48.7 | ||

| Code | HumanEval-Mul (Pass@1) | 69.3 | 77.4 | 77.3 | 77.2 | 81.7 | 80.5 | 82.6 |

| LiveCodeBench (Pass@1-COT) | 18.8 | 29.2 | 31.1 | 28.4 | 36.3 | 33.4 | 40.5 | |

| LiveCodeBench (Pass@1) | 20.3 | 28.4 | 28.7 | 30.1 | 32.8 | 34.2 | 37.6 | |

| Codeforces (Percentile) | 17.5 | 35.6 | 24.8 | 25.3 | 20.3 | 23.6 | 51.6 | |

| SWE Verified (Resolved) | 22.6 | 23.8 | 24.5 | 50.8 | 38.8 | 42.0 | ||

| Aider-Edit (Acc.) | 60.3 | 71.6 | 65.4 | 63.9 | 84.2 | 72.9 | 79.7 | |

| Aider-Polyglot (Acc.) | 18.2 | 7.6 | 5.8 | 45.3 | 16.0 | 49.6 | ||

| AIME 2024 (Pass@1) | 4.6 | 16.7 | 23.3 | 23.3 | 16.0 | 9.3 | 39.2 | |

| MATH-500 (EM) | 56.3 | 74.7 | 80.0 | 73.8 | 78.3 | 74.6 | 90.2 | |

| CNMO 2024 (Pass@1) | 2.8 | 10.8 | 15.9 | 6.8 | 13.1 | 10.8 | 43.2 | |

| CLUEWSC (EM) | 89.9 | 90.4 | 91.4 | 84.7 | 85.4 | 87.9 | 90.9 | |

| Chinese C-Eval (EM) C-SimpleQA (Correct) | 78.6 48.5 | 79.5 54.1 | 86.1 48.4 | 61.5 50.4 | 76.7 51.3 | 76.0 59.3 | 86.5 64.8 |

数据来源:DeepSeek 官方,财通证券研究所注:所有模型均在将输出长度限制为 8K 的配置下进行评估。对于包含少于 1000 个样本的基准测试,会使用不同的温度设置多次测试,以便得出可靠的最终结果。结果显示,DeepSeek-V3 是性能最佳的开源模型,与前沿的闭源模型相比,也展现出了颇具竞争力的性能。

3 完整训练仅需 278.8 万 H800GPU 小时,高性价比追求普惠 AGI

DeepSeek-V3 的完整训练仅需 278.8 万 H800GPU 小时,包含预训练、上下文长度扩展和后训练。根据官方论文,其训练过程非常稳定,没有遇到任何不可恢复的损失峰值或进行任何回滚操作。同时,DeepSeek-V3 采用了 FP8 混合精度训练框架,这是首次在超大规模模型上验证 FP8 训练的可行性和有效性。综合评估表明,DeepSeek-V3 是目前最强的开源模型,性能可与闭源模型如 GPT-4o-0513 和Claude-3.5-Sonnet-1022 相媲美。

DeepSeek-V3 端到端生成速度较 DeepSeek-V2 提升两倍多,并仍有进一步提升潜力。在 DeepSeek 最新论文中提到,DeepSeek - V3 部署策略已经实现了端到端生成速度是 DeepSeek - V2 的两倍多。另外,随着性能更强、速度更快的 DeepSeek-V3 更新上线,DeepSeek-V3 模型 API 服务定价也将调整为每百万输入 tokens0.5 元(缓存命中)/ 2 元(缓存未命中),每百万输出 tokens 8 元,是当前模型性能/价格比最优的模型服务。

图9. MMLU Redux ZeraEval 得分 vs. 输入 API 价格(¥/1M Tokens)

数据来源:DeepSeek 官网,财通证券研究所

DeepSeek 最后在论文中表示,未来将持续研究和优化模型架构,提高训练和推理效率,突破 Transformer 架构限制;对训练数据的数量和质量进行迭代,并探索更多训练信号源;不断探索和提升模型的深度思考能力,通过拓展推理长度和深度增强其智能与问题解决能力;探索更全面、多维度的模型评估方法,避免研究中仅针对固定基准优化带来的误导。

风险提示

技术迭代不及预期的风险:若 AI 技术迭代不及预期,NLP 模型优化受限,则相关产业发展进度会受到影响。

商业化落地不及预期的风险:大模型盈利模式尚处于探索阶段,后续商业化落地进展有待观察。

政策支持不及预期风险:新行业新技术的推广需要政策支持,存在政策支持不及预期风险。

全球宏观经济风险:垂直领域公司与下游经济情况相关,存在全球宏观经济风险。

信息披露

分析师承诺

作者具有中国证券业协会授予的证券投资咨询执业资格,并注册为证券分析师,具备专业胜任能力,保证报告所采用的数据均来自合规渠道,分析逻辑基于作者的职业理解。本报告清晰地反映了作者的研究观点,力求独立、客观和公正,结论不受任何第三方的授意或影响,作者也不会因本报告中的具体推荐意见或观点而直接或间接收到任何形式的补偿。

资质声明

财通证券股份有限公司具备中国证券监督管理委员会许可的证券投资咨询业务资格。

公司评级

以报告发布日后 6 个月内,证券相对于市场基准指数的涨跌幅为标准:

买入:相对同期相关证券市场代表性指数涨幅大于 $10%$ ;

增持:相对同期相关证券市场代表性指数涨幅在 $5%{\sim}10%$ 之间;

中性:相对同期相关证券市场代表性指数涨幅在- $-5%\sim5%$ 之间;

减持:相对同期相关证券市场代表性指数涨幅小于- $-5%$ ;

无评级:由于我们无法获取必要的资料,或者公司面临无法预见结果的重大不确定性事件,或者其他原因,致使我们无法给出明确的投资评级。

A 股市场代表性指数以沪深 300 指数为基准;中国香港市场代表性指数以恒生指数为基准;美国市场代表性指数以标普 500指数为基准。

行业评级

以报告发布日后 6 个月内,行业相对于市场基准指数的涨跌幅为标准:

看好:相对表现优于同期相关证券市场代表性指数;

中性:相对表现与同期相关证券市场代表性指数持平;

看淡:相对表现弱于同期相关证券市场代表性指数。

A 股市场代表性指数以沪深 300 指数为基准;中国香港市场代表性指数以恒生指数为基准;美国市场代表性指数以标普 500指数为基准。

免责声明

本报告仅供财通证券股份有限公司的客户使用。本公司不会因接收人收到本报告而视其为本公司的当然客户。

本报告的信息来源于已公开的资料,本公司不保证该等信息的准确性、完整性。本报告所载的资料、工具、意见及推测只提供给客户作参考之用,并非作为或被视为出售或购买证券或其他投资标的邀请或向他人作出邀请。

本报告所载的资料、意见及推测仅反映本公司于发布本报告当日的判断,本报告所指的证券或投资标的价格、价值及投资收入可能会波动。在不同时期,本公司可发出与本报告所载资料、意见及推测不一致的报告。

本公司通过信息隔离墙对可能存在利益冲突的业务部门或关联机构之间的信息流动进行控制。因此,客户应注意,在法律许可的情况下,本公司及其所属关联机构可能会持有报告中提到的公司所发行的证券或期权并进行证券或期权交易,也可能为这些公司提供或者争取提供投资银行、财务顾问或者金融产品等相关服务。在法律许可的情况下,本公司的员工可能担任本报告所提到的公司的董事。

本报告中所指的投资及服务可能不适合个别客户,不构成客户私人咨询建议。在任何情况下,本报告中的信息或所表述的意见均不构成对任何人的投资建议。在任何情况下,本公司不对任何人使用本报告中的任何内容所引致的任何损失负任何责任。

本报告仅作为客户作出投资决策和公司投资顾问为客户提供投资建议的参考。客户应当独立作出投资决策,而基于本报告作出任何投资决定或就本报告要求任何解释前应咨询所在证券机构投资顾问和服务人员的意见;

本报告的版权归本公司所有,未经书面许可,任何机构和个人不得以任何形式翻版、复制、发表或引用,或再次分发给任何其他人,或以任何侵犯本公司版权的其他方式使用。

免责申明:

- 本资料来源于网络公开渠道,版权归属版权方;

- 本资料仅限会员学习使用,如他用请联系版权方;

- 会员费用作为信息收集整理及运营之必须费用;

- 如侵犯您的合法权益,请联系客服微信将及时删除

行业报告资源群

- 进群福利:进群即领万份行业研究、管理方案及其他学

习资源,直接打包下载 - 每日分享:6份行研精选报告、3个行业主题

- 报告查找:群里直接咨询,免费协助查找

- 严禁广告:仅限行业报告交流,禁止一切无关信息

微信扫码,长期有效

知识星球 行业与管理资源

专业知识社群:每月分享8000+份行业研究报告、商业计划、市场研究、企业运营及咨询管理方案等,涵盖科技、金融、教育、互联网、房地产、生物制药、医疗健康等;已成为投资、产业研究、企业运营、价值传播等工作助手。

文章作者 大模型

上次更新 2025-03-09