17__几何角度看分类:支持向量机

文章目录

前文中介绍过的逻辑回归是基于似然度的分类方法,通过对数据概率建模来得到软输出。而在另一类基于判别式的硬输出分类方法中,代表性较强的就得数今天要介绍的支持向量机了。

支持向量机并不关心数据的概率,而是要基于判别式找到最优的超平面作为二分类问题的决策边界。其发明者弗拉基米尔·瓦普尼克(Vladimir Vapnik)用一句名言清晰地解释了他的思想:能走直线就别兜圈子。

当然啦,这是“信达雅”的译法,老瓦的原话是“不要引入更加复杂的问题作为解决当前问题的中间步骤(When trying to solve some problem, one should not solve a more difficult problem as an intermediate step. )”。

在他看来,估算数据的概率分布就是那个作为中间步骤的复杂问题。这就像当一个人学习英语时,他只要直接报个班或者自己看书就行了,而不需要先学习诘屈聱牙的拉丁语作为基础。既然解决分类问题只需要一个简单的判别式,那就没有必要费尽心机地去计算似然概率或是后验概率。正是这化繁为简的原则给支持向量机带来了超乎寻常的优良效果。

一提到支持向量机,大部分人的第一反应都是核技巧。可核技巧诞生于 1995 年,而支持向量机早在 30 年前就已经面世。支持向量机(support vector machine)是基于几何意义的非概率线性二分类器,所谓的核技巧(kernel trick)只是支持向量机的一个拓展,通过维度的升高将决策边界从线性推广为非线性。所以对于支持向量机的基本原则的理解与核技巧无关,而是关乎决策边界的生成方式。

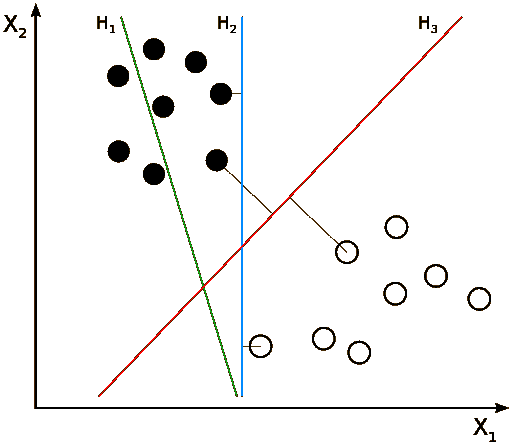

线性可分数据集的决策边界(图片来自维基百科)

想象一下,如果一个数据集是二维平面上的线性可分数据集,那它的决策边界就是一条简单的直线。可这条能将所有训练数据正确区分的直线是不是唯一的呢?显然,答案是否定的,因为两个最近的异类点之间存在一段距离,这从上图中就能看出。事实上,像这样的能正确区分数据的直线有无数条。

那么问题来了:在这些直线里,哪一条是最好的呢?这里我们抛开复杂的数学证明,而是通过直观的几何视角来解释:回头看看上面的示意图,蓝色直线 H2H2

文章作者

上次更新 2025-01-03